Quando nel 2009 venne scoperto il nuovo ceppo di influenza H1N1, negli USA fu attivata la consueta procedura di monitoraggio e osservazione, che prevedeva la segnalazione di tutti i casi da parte dei centri sanitari regionali di controllo e prevenzione.

Una procedura capillare e rodata, che aveva però un limite: delineava un quadro dello sviluppo del virus sempre in ritardo di due settimane rispetto alla situazione contingente.

Nello stesso periodo, la rivista Nature pubblicò un articolo nel quale alcuni ingegneri di Google, tra lo stupore e l’incredulità generali, affermavano di poter ricavare e anzi prevedere la diffusione geografica di H1N1 basandosi esclusivamente sulle parole chiave utilizzate nel web.

Nello specifico, partendo dai 50 milioni di parole maggiormente usate in rete dagli utenti statunitensi, i guru di Mountain View avevano individuato quelle più utilizzate nelle aree segnalate dai centri sanitari regionali, e applicandovi 450 milioni di diversi modelli matematici erano riusciti a evidenziare una correlazione tra 45 parole chiave e l’espansione del virus.

I fatti confermarono la notizia, e per la prima volta fu dimostrato che era possibile predire la diffusione di un virus con metodi squisitamente matematici, facendo ricorso essenzialmente a (enormi) quantità di dati processati da macchine con adeguate capacità di calcolo.

Questa storia è una ulteriore riprova di quanto la rivoluzione digitale, fondata sulla Information Tecnology (IT), abbia rivoluzionato la nostra epoca. Da essa ha avuto inizio quella che viene indicata come “quarta rivoluzione industriale”, un cambiamento epocale che si sta sviluppando con un’ampiezza e una velocità mai viste, investendo una pluralità di campi come mai accaduto prima.

Intelligenza Artificiale (IA), robotica, biotecnologie, nanotecnologie, internet delle cose (IoT), guida autonoma, calcolo quantistico sono solo alcuni dei settori che stanno attraversando un periodo di continui progressi, straordinario per la varietà e profondità dei risultati e per la sua velocità di sviluppo.

Dell’acronimo IT, sovente, ci si sofferma sulla T di tecnologia, cioè i computer: macchine sempre più potenti, in grado di raddoppiare le capacità di calcolo ogni 18 mesi, secondo una legge - detta di Moore1 - che pur priva di valenza scientifica, è comunque suffragata da più 50 anni di osservazione della realtà.

Ciò detto, e nulla togliendo all’importanza derivante da macchine sempre più potenti, la vera ricchezza oggi risiede nei dati, anzi nei BIG DATA ricavati dai miliardi di informazioni prodotte ogni singolo istante dai nostri click, tweet e preferenze di acquisto.

Nel primo trimestre del 2018, Facebook aveva 2.19 miliardi di utenti attivi2, che a loro volta interagivano con 200 miliardi di altri individui del network: una cifra oltre il 20% della popolazione del pianeta. Nello stesso anno, YouTube si è attestato su un miliardo e mezzo di utenti, seguito da WhatsApp con un miliardo e trecento milioni.

Numeri importanti, che producono una inesauribile fonte di dati.

Quello del web, d’altronde, è un ambiente in cui giornalmente milioni di persone trascorrono una parte importante della loro vita (in Italia, in media 6 ore al giorno nel 2018), scambiando opinioni, emozioni, piaceri, dispiaceri, preferenze di acquisto e molto altro.

Un insieme di comportamenti individuali che possono essere “datizzati”, ossia registrati, analizzati e riorganizzati secondo criteri scientifici che producono continuamente dati.

Due esempi, più di tutti rendono l’idea di come nelle informazioni si celino i risultati che cerchiamo.

Nel 2006, il portale AoL (Americaonline) ha reso pubblico, per studiosi e ricercatori, un database di 20 milioni di “interrogazioni” compiute nell’arco di tre mesi da 675mila utenti, e lo ha fatto rendendo preventivamente anonimi, per ragioni di tutela, gli utenti a vario titolo coinvolti. Ciò nonostante, dopo qualche giorno, una vedova sessantenne della Georgia, Thelma Arnold, è stata - a ragione - associata al numero utente 4417749, innescando una controversia che ha portato al licenziamento di tre dipendenti di AoL.

E anche quando Netflix ha pubblicato le preferenze di circa mezzo milione di utenti anonimi, non è passato molto tempo prima che una signora del Midwest venisse riconosciuta con nome e indirizzo. I ricercatori della Università del Texas hanno in seguito dimostrato come sia effettivamente possibile riconoscere un utente del canale dalla scelta di soli 6 film su 500.

Ma non solo di web si tratta: pensiamo alle telecamere, ovunque nelle strade e nelle piazze delle nostre città, e ai modi e finalità con cui le tracce che lasciamo possono essere utilizzate da appositi software di riconoscimento facciale (alcuni anni fa, un quotidiano inglese scoprì che a meno di 200 metri dalla casa in cui era vissuto George Orwell, l’autore del libro distopico “1984”, vi erano non meno di 30 telecamere).

Stando a quanto riferiscono Viktor Schonberger e Keneth Cukier nella loro opera fondamentale3 (utilizzata come fonte primaria per questo articolo) , nel 2012 sono stati prodotti così tanti dati che se caricati su CD-ROM avrebbero formato cinque pile parallele in grado di raggiungere la luna, mentre se fossero stati stampati su fogli di carta sarebbero stati in grado di coprire per ben tre volte l’intero territorio degli USA.

Si noti che parliamo di 6 anni fa, e che nel frattempo i dati prodotti ogni anno sono raddoppiati altre due volte (in media, un raddoppio ogni tre anni).

I dati costituiscono l’oro nero della nostra epoca: un valore inestimabile, per la quantità e la molteplicità di utilizzi, il più delle volte diversi da quelli per i quali sono stati in origine prelevati. Sempre più spesso, infatti, forniamo informazioni in rete per finalità che al momento della loro raccolta ancora non si conoscono.

I dati costituiscono l’oro nero della nostra epoca: un valore inestimabile, per la quantità e la molteplicità di utilizzi, il più delle volte diversi da quelli per i quali sono stati in origine prelevati. Sempre più spesso, infatti, forniamo informazioni in rete per finalità che al momento della loro raccolta ancora non si conoscono.

Essi alimentano la nuova frontiera dell’IA, costituendone il primo combustibile: è grazie a loro, che i computer progrediscono e si avviano a “percepire” la realtà esterna.

Loro tramite i robot iniziano a compiere azioni autonome4, decise sulla base di dati di situazione raccolti e analizzati all’esterno (e non della programmazione ricevuta).

Ma come vengono utilizzati i BIG DATA? Applicandovi metodi matematici, “algoritmi”, elaborati sulla base di cosa si vuole scoprire in un dato momento, di un particolare fenomeno.

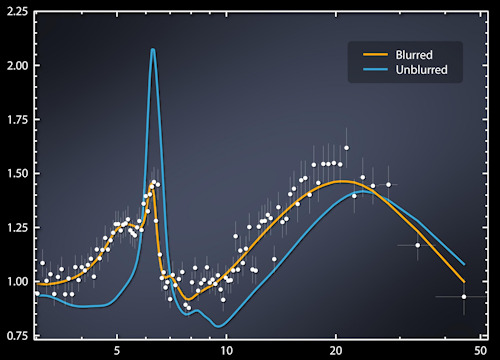

Sono gli algoritmi, che sfruttando grandi quantità di dati, permettono di scorgervi eventuali “correlazioni”, intese come probabilità che una data relazione tra gli elementi esaminati possa ripetersi.

Che poi tali legami emergano per pura coincidenza, nulla toglie alla validità dello studio in sé, in quanto l’imprecisione e l’inesattezza vengono statisticamente “aggiustate” in proporzione al numero dei dati a disposizione.

Con buona pace del principio di causalità, che andava bene nell’epoca degli SMALL DATA quando la comprensione si basava su una analisi attenta dei (limitati) elementi a disposizione, svolta da gente “esperta” nel particolare settore oggetto di studio.

Nell’epoca dei BIG DATA, alla comprensione dei fenomeni si perviene invece con l’aiuto di “data scientist” - una via di mezzo tra un programmatore, un matematico e uno statistico -, e non degli esperti tradizionali.

Nei grandi dati, infatti, risiede la verità: non a caso, algoritmi che offrono risultati (probabilistici) poco soddisfacenti con quantità limitate di dati, funzionano alla meraviglia quando applicati su numeri maggiori.

“Google Translator” fornisce un chiaro esempio di come il criterio probabilistico unito alla quantità di informazioni possa essere applicato per risolvere un problema complesso come la traduzione.

Il programma, infatti, non traduce applicando le regole grammaticali o ricorrendo ai dizionari memorizzati, ma basandosi sulle probabilità che il contenuto di un dato documento possa essere tradotto secondo le strutture grammaticali e i significati di parole, verbi e aggettivi presenti nei miliardi di documenti, in tutte le lingue, che ha in memoria.

In questo modo, il programma ha vinto la competizione con Microsoft ed è diventato in poco tempo il traduttore più utilizzato al mondo.

In un tale contesto, come già accennato, la capacità di calcolo rappresenta solo una parte del processo, neppure quella più importante, così come gli algoritmi che vengono di volta in volta utilizzati. Il fattore determinante resta il numero dei dati a disposizione: più se ne hanno, maggiori probabilità abbiamo di trovare quello che cerchiamo.

I BIG DATA “mettono le ali” alla quarta rivoluzione industriale, e consentono una maggiore comprensione del mondo. Imparare a gestirli e usarli al meglio, è la sfida che ci attende.

3BIG DATA di Viktor Schonberger e Keneth Cukier - Garzanti 2013

4Un sistema si dice “automatizzato” quando agisce principalmente in modo deterministico, reagendo sempre allo stesso modo quando sottoposto ai medesimi input. Un sistema “autonomo”, invece, ragiona su base probabilistica: ricevuta una serie di input, elabora le migliori risposte. A differenza di quanto accade con i sistemi automatizzati, un sistema autonomo, a parità di input, può produrre risposte differenti.

Foto: Emilio Labrador / NASA